Web Scraping — технология, тесно связанная с проксированием трафика. Но прежде, чем приступать к рассмотрению самой технологии, давайте определимся с терминами. Web Scraping — термин, обозначающий автоматизированный сбор данных из открытых веб-источников. В русскоязычном сегменте интернета эту процедуру обычно называют парсингом, что вносит путаницу.

Несмотря на то, что в ряде источников можно прочитать различные определения для веб-скрейпинг и парсинга — это разные названия одной и той же технологии. Хотя, если это по каким-то причинам будет необходимо, то можно провести такое разделение на этапы:

- веб-скрейпинг — непосредственно сам автоматизированный сбор различных данных;

- парсинг — обзор, форматирование и структурирование собранных данных для последующего анализа.

Но в целом можно весь процесс называть либо веб-скрейпинг, либо парсинг — в русскоязычном сегменте более популярен термин «Парсинг».

Зачем вообще собирать данные с разных сайтов?

Существует большое количество ситуаций, в которых веб-скрейпинг может существенно повысить как эффективность работы компании, так и точность различных исследований и отчетов.

Для компаний парсинг полезен в первую очередь тем, что позволяет анализировать деятельность конкурентов и на основе этой аналитики выстраивать собственные успешные стратегии развития. К примеру, частыми направлениями парсинга становятся:

- отслеживание цен — сбор информации о ценах на предложения конкурентов, размещенные на разных площадках, позволят своевременно реагировать на их изменения, извлекая выгоду как от их повышения, так и от понижения;

- описание товаров и услуг — дает возможность контролировать не просто ассортимент товаров и услуг, предлагаемых конкурентами, но и их востребованность, если сервис предоставляет данные о количестве продаж, поступлений, остатка на складах и так далее.

Для аналитики можно собирать любые данные, например, количество проставленных покупателями лайков к тому или иному товару, сортировать по ключевым словам отзывы и комментарии.

Парсинг полезен не только для продаж, но и для любой аналитической деятельности в сети: мониторинг новостных тем, переписок на форумах, объявлений на сайтах и так далее. Аналитика не может существовать без данных, но не все веб-ресурсы готовы ими делиться, предлагая свое API — приходится прибегать к веб-скрейпингу.

Как устроена технология веб-скрейпинга

Если говорить о том, что она делает, то тут все относительно просто: копирует данные с сайтов и вставляет их в различные таблички для последующего анализа. Точно так же это мог бы делать и человек, просто это заняло бы у него намного больше времени. К примеру, требуется сравнить стоимость поездки на общественном транспорте в ряде крупных городов — потребуется найти профильные сайты и скопировать информацию, содержащуюся на них, в свой документ для сравнения.

Можно это сделать «вручную», а можно спарсить нужные данные — это будет быстрее, особенно, если усложнить задачу и учитывать дополнительные параметры: продолжительность маршрутов, их частоту и другие.

Если говорить о том, как она это делает, то тут уже сложнее — существует множество различных решений, лучшим из которых будет воспользоваться официальным API, если это доступно в рамках решаемой задачи. Но, как мы упоминали выше, редко какие сайты и приложения предлагают свои API для неограниченной работы с данными — тут поможет веб-скрейпинг.

Существует много способов автоматизировать сбор данных. Среди полноценных инструментов можно выделить фреймворки:

- Scrapy — фреймворк, написанный на Python, поддерживающий проксирование трафика с использованием множества адресов;

- Selenium — из коробки поддерживает JavaScript и большое количество языков программирования;

- Apify SDK — поддерживает проксирование, хорошо подходит для крупных проектов за счет высокой расширяемости.

Среди готовых инструментов стоит отметить: Octoparse, ParseHub и PhantomBuster — они проще фреймворков и лучше подойдут новичкам для решения небольших задач.

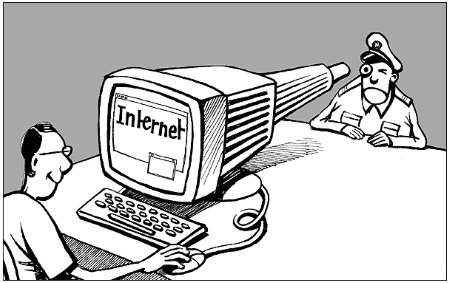

Web Scraping с точки зрения закона

Закон прямо не регулирует деятельность, связанную с веб-скрейпингом, но существуют правила хорошего тона, которые позволяют добиваться целей, не принося существенного вреда веб-ресурсам.

Вот некоторые из них:

- не игнорируйте robots.txt — там обычно есть информация, предписывающая не индексировать определенные страницы сайта;

- не перегружайте сайты запросами — особенно это касается небольших веб-сервисов;

- используйте непиковые часы — у большинства ресурсов нагрузка на серверы снижается ночью.

Контент и изображения часто бывают защищены авторским правом, это нужно учитывать при работе с парсерами, чтобы оставаться в рамках закона.

Качественные прокси для Web Scraping можно приобрести на нашем сайте.